深度學習是人工智能 (AI) 中發展迅速的領域之一,可幫助計算機理解大量圖像、聲音和文本形式的數據。利用多層次的神經網絡,現在的計算機能像人類一樣觀察、學習復雜的情況,并做出相應的反應,有時甚至比人類做得還好。這樣便提供了一種截然不同的方式,用于思考數據、技術以及人類所提供的產品和服務。

工業與學術界的數據科學家已將 GPU 用于機器學習以便在各種應用上實現開創性的改進,這些應用包括圖像分類、視頻分析、語音識別以及自然語言處理等等。 尤其是深度學習,人們在這一領域中一直進行大力投資和研究。深度學習是利用復雜的多級「深度」神經網絡來打造一些系統,這些系統能夠從海量的未標記訓練數 據中進行特征檢測。

雖然機器學習已經有數十年的歷史,但是兩個較為新近的趨勢促進了機器學習的廣泛應用: 海量訓練數據的出現以及 GPU 計算所提供的強大而高效的并行計算。 人們利用 GPU 來訓練這些深度神經網絡,所使用的訓練集大得多,所耗費的時間大幅縮短,占用的數據中心基礎設施也少得多。 GPU 還被用于運行這些機器學習訓練模型,以便在云端進行分類和預測,從而在耗費功率更低、占用基礎設施更少的情況下能夠支持遠比從前更大的數據量和吞吐量。

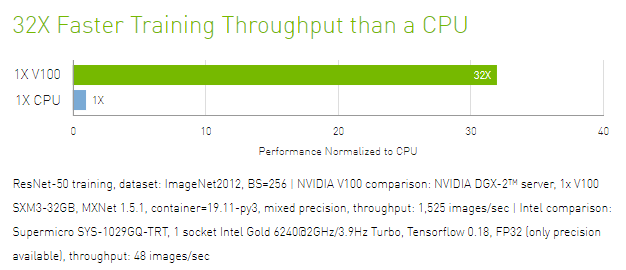

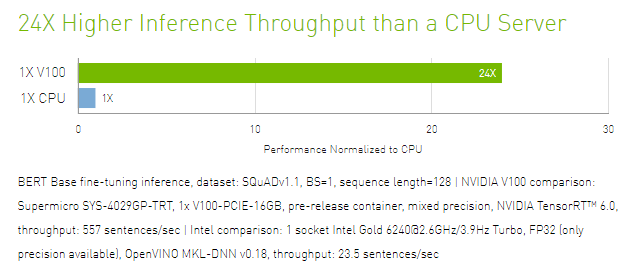

將 GPU 加速器用于機器學習的早期用戶包括諸多規模的網絡和社交媒體公司,另外還有數據科學和機器學習領域中一流的研究機構。 與單純使用 CPU 的做法相比,GPU 具有數以千計的計算核心、可實現 10-100 倍應用吞吐量,因此 GPU 已經成為數據科學家處理大數據的處理器。

Copyright ? 2019-2024 青島希諾智能科技有限公司版權所有 備案號:魯ICP備19042003號-1

技術支持:微動力網絡